Arriva Minerva 7B, l’ultima versione del modello linguistico sviluppato all’Università Sapienza di Roma nell’ambito del Progetto FAIR, Future Artificial Intelligence Research, in collaborazione con CINECA che ha reso fruibile l’uso del supercomputer Leonardo.

Il team di lavoro del gruppo di ricerca Sapienza NPL, Natural Language Processing, che ha collaborato per dar vita a Minerva 7B, è stato guidato da Roberto Navigli professore di Natural Language Processing e composto da Alessandro Scirè, Edoardo Barba, Federico Martelli, Luca Moroni, Pere-Lluís Huguet Cabot, Riccardo Orlando, Simone Conia, Simone Tedeschi, Tommaso Bonomo, e hanno contribuito anche Ciro Porcaro, Fabrizio Brignone, Francesco Cecconi, Stefan Bejgu, Simone Stirpe.

La nuova Minerva 7B è stata addestrata con 1,5 trilioni di parole, quindi, è in grado di lavorare con 7 miliardi di parametri, al contrario della versione precedente, in cui erano 3. Il nuovo modello linguistico sembra essere la risposta italiana a ChatGpt, capace di produrre testi da un prompt di base, ma addestrata completamente nella nostra lingua.

Come funziona Minerva 7B?

Il team di ricerca presso l’Università Sapienza di Roma ha esposto Minerva 7B a un processo di addestramento di instruction tuning, di norma utilizzato per i modelli che lavorano con l’AI, affinché possa fornire delle risposte adeguate alle domande formulate dall’utente italiano che la consulterà.

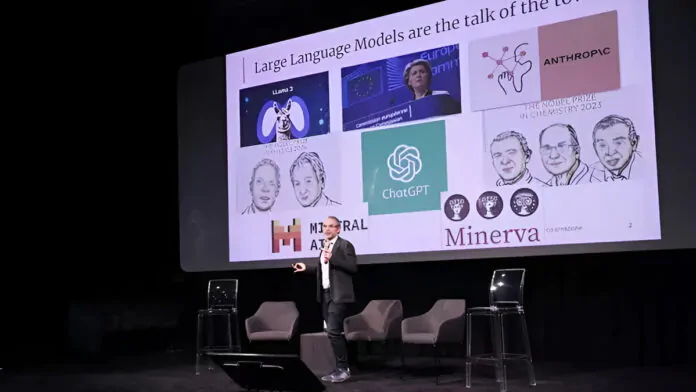

Ecco le parole del professor Roberto Navigli durante la presentazione ufficiale svoltasi ieri mattina presso l’Università Sapienza di Roma: “Presentiamo un nuovo passo importante del primo modello pre-addestrato in lingua italiana stile ChatGpt, quindi un modello linguistico, che si chiama Minerva 7B, ossia sviluppato usando ben 7 miliardi di parametri”.

Rispetto alla versione precedente possiede una maggiore capacità di elaborazione di testi scritti basata su informazioni che trae da fonti aperte di dati. Inoltre, vi è un’importante novità rispetto ai modelli linguistici come ChatGpt, come ha sottolineato Roberto Navigli:

A differenza di ChatGpt o Gemini, che sono modelli chiusi così come anche Mistral o Llama3 che sono scaricabili, Minerva appartiene a quella ristretta famiglia di modelli aperti, ossia che è possibile analizzare liberamente.

Sarà, infatti, possibile analizzare il codice per poterlo migliorare.

Più precisione e sicurezza con Minerva 7B

Durante la presentazione ufficiale, Roberto Navigli ha dimostrato alcune funzionalità di Minerva 7B, tra cui l’elaborazione, trascrizione e riassunto di un testo. In particolare, il professore presso l’Università Sapienza di Roma ha svelato che, ancora rispetto alla versione precedente, il modello linguistico è più sicuro:

È addestrato anche per rispondere a domande e istruzioni, comandi ed è particolarmente interessante perché abbiamo fatto un lavoro importante sulla sicurezza del modello, la cosiddetta safety, cioè la capacità del modello di evitare e rispondere a domande che potrebbe portare alla generazione di contenuti indesiderati o malevoli.

Il team di ricerca dell’Università Sapienza di Roma, però, non si ferma qui, ma lavorerà per ampliare i campi di applicazione di Minerva 7B, come ha evidenziato Navigli:

Minerva è il primo e a oggi unico modello completamente aperto, che si presta a essere utilizzato dalle Pubbliche amministrazioni, proprio per la trasparenza delle fonti e del processo di addestramento.

Il nostro impegno è continuare a lavorare per massimizzare la sicurezza e gli aspetti conversazionali in una sorta di laboratorio permanente, con la consapevolezza scientifica che il rilascio di oggi non è un traguardo, ma un punto di partenza

La scarsità di dati di qualità in italiano, sia per il pre-addestramento linguistico che per le conversazioni e le istruzioni, è uno dei temi chiave che intendiamo affrontare nei prossimi mesi.

In quest’ottica auspichiamo che il progetto possa crescere aprendosi a nuove collaborazioni, coinvolgendo ad esempio il mondo editoriale ed enti pubblici per l’impiego di Minerva in ambiti istituzionali.

Leggi anche: Intelligenza Artificiale e Machine Learning: come funzionano